DeepSeek满血版本地化傻瓜式可视化部署方案

一、方案背景与目标

背景

DeepSeek作为先进的大语言模型,具备强大的语言理解和生成能力。将其进行本地化部署,能够在保障数据安全和隐私的同时,满足特定场景下的高效使用需求。本方案旨在为非专业技术人员提供一种简单、直观的方式,实现DeepSeek满血版的本地部署与使用。

目标

通过傻瓜式、可视化的部署流程,让用户能够轻松在本地环境搭建DeepSeek模型,并通过可视化界面与之交互,完成文本生成、问答等任务。

二、准备工作

硬件要求

| 硬件组件 | 推荐配置 | 说明 |

|---|---|---|

| CPU | Intel Core i7 及以上或 AMD Ryzen 7 及以上 | 多核心处理器可加速模型推理过程 |

| 内存 | 16GB 及以上 | 足够的内存可避免因内存不足导致的程序崩溃 |

| 硬盘 | 512GB 及以上 SSD | 快速的读写速度可加快模型文件加载和数据处理 |

| GPU | NVIDIA GeForce RTX 3060 及以上 | 支持 CUDA 加速,显著提升模型运行效率 |

| 网络 | 稳定的宽带网络 | 用于下载软件、代码和模型文件 |

软件准备

Anaconda

Anaconda 是一个开源的 Python 发行版本,包含了 Python、众多科学计算库以及包管理工具 conda。

- 下载:访问 Anaconda 官网(https://www.anaconda.com/download ),根据自己的操作系统(Windows、Mac OS、Linux)选择对应的安装包进行下载。

- 安装:运行下载好的安装包,按照安装向导的提示进行操作。在安装过程中,建议勾选“Add Anaconda to my PATH environment variable”选项,以便在命令行中可以直接使用 conda 命令。

Git 客户端

Git 是一种分布式版本控制系统,用于管理代码的版本和协作开发。

- 下载:访问 Git 官网(https://git-scm.com/downloads ),选择适合自己操作系统的版本进行下载。

- 安装:运行下载好的安装包,按照默认设置完成安装。安装完成后,在命令行中输入

git --version验证安装是否成功。

NVIDIA 驱动

如果你的计算机配备了 NVIDIA GPU,需要安装相应的驱动程序以支持 CUDA 加速。

- 下载:访问 NVIDIA 官网(https://www.nvidia.com/Download/index.aspx ),根据自己的 GPU 型号、操作系统和 CUDA 版本选择合适的驱动程序进行下载。

- 安装:运行下载好的驱动程序安装包,按照安装向导的提示完成安装。安装完成后,在命令行中输入

nvidia-smi验证驱动是否安装成功。

CUDA 和 cuDNN(可选但推荐)

CUDA 是 NVIDIA 推出的并行计算平台和编程模型,cuDNN 是 NVIDIA 提供的深度神经网络库,它们可以显著加速基于 GPU 的深度学习模型训练和推理。

- CUDA 安装:访问 NVIDIA CUDA 官网(https://developer.nvidia.com/cuda-downloads ),选择适合自己操作系统的 CUDA 版本进行下载和安装。安装过程中按照提示进行操作,注意记录安装路径。

- cuDNN 安装:访问 NVIDIA cuDNN 官网(https://developer.nvidia.com/cudnn ),注册并登录后下载与 CUDA 版本兼容的 cuDNN 库。将下载的压缩包解压后,将其中的文件复制到 CUDA 安装目录对应的文件夹中。

三、部署步骤

1. 创建并激活 Anaconda 环境

- 打开 Anaconda Prompt(Windows)或终端(Mac OS、Linux)。

- 输入以下命令创建一个名为

deepseek_env的 Python 3.8 环境:conda create -n deepseek_env python=3.8 - 输入以下命令激活该环境:

conda activate deepseek_env

2. 获取 DeepSeek 代码

- 在激活的 Anaconda 环境下,打开 Git Bash(Windows)或终端(Mac OS、Linux)。

- 输入以下命令将 DeepSeek 代码克隆到本地:

git clone <DeepSeek代码仓库地址>请将

<DeepSeek代码仓库地址>替换为 DeepSeek 官方提供的真实代码仓库链接。如果代码仓库是私有的,可能需要输入用户名和密码进行身份验证。

3. 安装依赖包

- 进入克隆下来的 DeepSeek 代码目录,例如:

cd deepseek - 输入以下命令安装运行所需的依赖包:

pip install -r requirements.txt安装过程可能会持续一段时间,具体时间取决于网络速度和依赖包的数量。如果在安装过程中遇到问题,可以尝试使用国内镜像源加速下载,例如:

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

4. 下载模型文件

- 从 DeepSeek 官方指定的模型下载地址获取满血版模型文件。这些文件可能包含模型权重、配置文件等。

- 创建一个

models文件夹用于存放模型文件:mkdir models - 将下载好的模型文件解压到

models文件夹中。确保文件路径与代码中配置的模型路径一致。

5. 配置环境变量(可选)

如果安装了 CUDA 和 cuDNN,需要配置相应的环境变量,以便程序能够正确找到这些库。

- 在 Windows 系统中,右键点击“此电脑”,选择“属性” -> “高级系统设置” -> “环境变量”,在系统变量中添加以下变量:

CUDA_PATH:指向 CUDA 安装目录,例如C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.7PATH:在原有的PATH变量中添加%CUDA_PATH%\bin和%CUDA_PATH%\libnvvp

- 在 Linux 或 Mac OS 系统中,编辑

~/.bashrc或~/.zshrc文件,添加以下内容:export PATH=/usr/local/cuda/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH然后执行

source ~/.bashrc或source ~/.zshrc使配置生效。

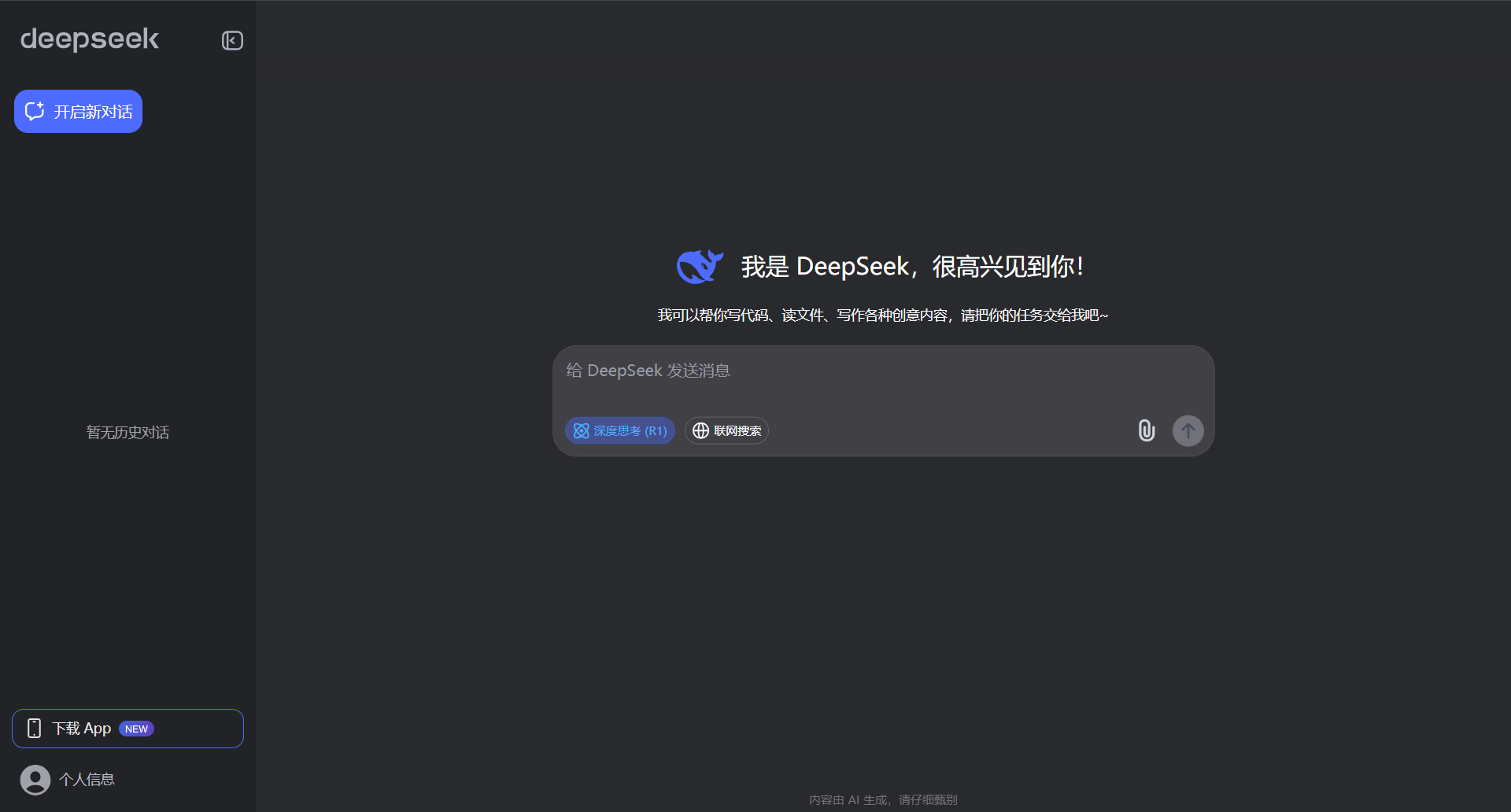

6. 启动可视化界面

- 在代码目录下,输入以下命令启动可视化界面:

python app.py - 启动成功后,会在命令行中显示一个本地链接,如

http://127.0.0.1:7860。 - 打开浏览器,输入该链接,即可看到 DeepSeek 的可视化界面。

四、测试与优化

简单测试

- 在可视化界面中输入一些测试文本,例如:“介绍一下人工智能”,然后点击生成按钮。

- 观察生成结果是否符合预期,包括文本的逻辑性、语法正确性和相关性。

- 如果生成结果出现错误或不符合要求,可以尝试调整输入文本的表述方式或修改模型的参数设置。

性能优化

调整模型参数

- 在可视化界面的设置选项中,通常可以找到一些模型参数,如生成的最大长度、采样温度等。

- 最大长度:适当降低最大长度可以减少生成时间,但可能会导致生成的文本不够完整。

- 采样温度:降低采样温度可以使生成的文本更加确定和保守,提高采样温度可以使生成的文本更加多样化和随机。

资源管理

- 定期清理缓存文件,释放硬盘空间。可在代码目录下找到缓存文件夹进行清理。

- 关闭不必要的后台程序,以确保计算机有足够的资源用于运行 DeepSeek 模型。

硬件升级

如果在使用过程中发现性能仍然无法满足需求,可以考虑升级硬件,如增加内存、更换更强大的 GPU 等。

五、常见问题及解决方法

依赖包安装失败

- 问题描述:在执行

pip install -r requirements.txt时,部分依赖包安装失败。 - 解决方法:

- 检查网络连接是否稳定,尝试使用国内镜像源加速下载。

- 查看错误信息,可能是某些依赖包版本不兼容。可以尝试手动安装指定版本的依赖包,例如

pip install package_name==version_number。

模型文件加载失败

- 问题描述:启动可视化界面时,提示模型文件加载失败。

- 解决方法:

- 检查模型文件是否完整下载并解压到正确的目录。

- 确保代码中配置的模型路径与实际模型文件路径一致。

GPU 加速未生效

- 问题描述:计算机配备了 NVIDIA GPU,但在运行过程中未使用 GPU 加速。

- 解决方法:

- 检查 NVIDIA 驱动、CUDA 和 cuDNN 是否正确安装并配置。

- 在代码中添加相应的 GPU 配置代码,例如:

import torch device = torch.device("cuda" if torch.cuda.is_available() else "cpu") model.to(device)

六、总结

通过以上步骤,你可以轻松地在本地环境实现 DeepSeek 满血版的傻瓜式、可视化部署。在部署过程中,按照准备工作的要求确保硬件和软件环境的正确性,严格遵循部署步骤进行操作。遇到问题时,参考常见问题及解决方法进行排查和修复。

文章标题:DeepSeek 满血版本地化傻瓜式可视化部署方案

文章链接:https://zhongke.fun/AI/dmxbbdhsgskshbsfa.html

本站文章均为原创,未经授权请勿用于任何商业用途

推荐阅读:

评论一下?