deepseek本地部署

第一步:安装ollama

第二步:在ollama 官网搜索

模型大小与显卡需求

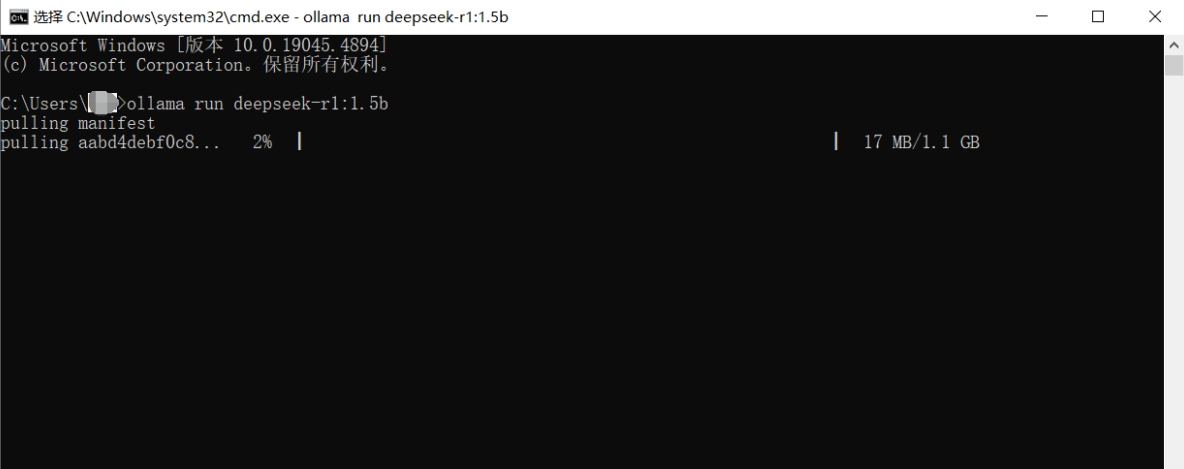

第三步:在终端执行 命令

等待安装即可

第五步:基本命令

#退出模型

>>> /bye

#查看模型

C:\Users\chk>ollama list

NAME ID SIZE MODIFIED

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 3 minutes ago

#启动模型

ollama run deepseek-r1:1.5b

>>>

#查看帮助

C:\Users\chk>ollama -h

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.可视化部署Web UI

第一步:下载Chatbox AI

设置中文

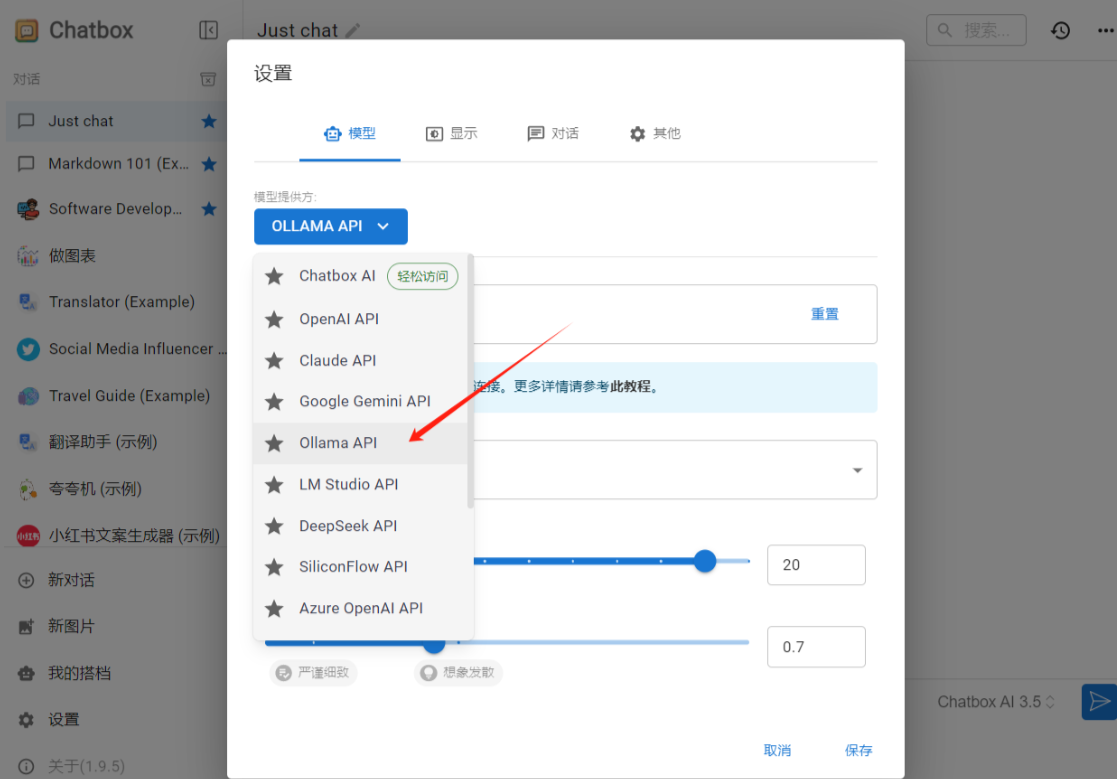

第二步:将 Chatbox 连接到远程 Ollama 服务

1.在 Windows 上配置环境变量

在 Windows 上,Ollama 会继承你的用户和系统环境变量。

通过任务栏退出 Ollama。

打开设置(Windows 11)或控制面板(Windows 10),并搜索“环境变量”。

点击编辑你账户的环境变量。

为你的用户账户编辑或创建新的变量 OLLAMA_HOST,值为 0.0.0.0; 为你的用户账户编辑或创建新的变量 OLLAMA_ORIGINS,值为 *。

点击确定/应用以保存设置。

从 Windows 开始菜单启动 Ollama 应用程序。2.服务 IP 地址

配置后,Ollama 服务将能在当前网络(如家庭 Wifi)中提供服务。你可以使用其他设备上的 Chatbox 客户端连接到此服务。Ollama 服务的 IP 地址是你电脑在当前网络中的地址。

3.注意事项

可能需要在防火墙中允许 Ollama 服务的端口(默认为 11434),具体取决于你的操作系统和网络环境。

为避免安全风险,请不要将 Ollama 服务暴露在公共网络中。家庭 Wifi 网络是一个相对安全的环境。

4.Chatbox配置模型

收藏

版权所有:中科随笔

文章标题:DeepSeek本地部署,保姆级教程,带你打造最强AI

文章链接:https://zhongke.fun/AI/dbdbs-bmjjc-dndzzja.html

本站文章均为原创,未经授权请勿用于任何商业用途

文章标题:DeepSeek本地部署,保姆级教程,带你打造最强AI

文章链接:https://zhongke.fun/AI/dbdbs-bmjjc-dndzzja.html

本站文章均为原创,未经授权请勿用于任何商业用途

推荐阅读:

扫描二维码,在手机上阅读

评论一下?